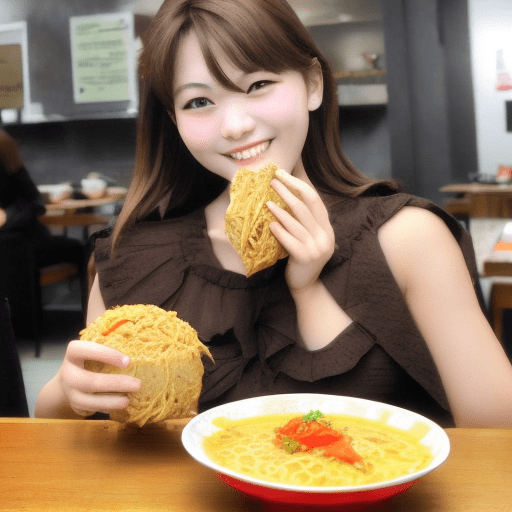

AIにラーメンを食べる女性を生成させたら、そのものズバリの画像を生成しました。

間違えてはいないものの、”eating ramen” の結果がこれでは、期待したものとは違う。いや、期待をはるかに凌ぐ結果と表記すべきなのでしょうか。このような画像が生成されるとは、全く考えてもいませんでした。

a japanese beauty loli, pretty girl, (eating ramen:1.63), at a Japanese restaurant, real, clear, (photo:1.68), front face

Steps: 40, Sampler: DPM++ SDE Karras, CFG scale: 6, Seed: 1517803603, Size: 512×512, Model hash: 0ff127093f, Model: Basil_mix_fixed, Clip skip: 6

ディープラーニングが不足しているのでしょうか。でも、AIは “ramen” という単語を正しく認識していることが分かります。

手に持っているのは、フライのようにも見えます。

下の画像は、確かにラーメンを食べようとしています。プロンプトの指示通りです。左手は服のどこから出ているのか分かりませんが、最近の流行なのかも。

ラーメンの食べ方は、箸を使うと指示しなかった管理人が悪いのでしょうか。それとも、ディープラーニングで学習した画像では、女性が替え玉を注文して、手でむしゃむしゃ食べるシーンが使われていたのでしょうか。

ラーメンを食べる女性に「箸」を追加すると、こんな画像を生成します。

「箸」を強調すると、こんな感じの画像が生成されます。

人間の発想からはこんな画像は出てこないと感じます。

ChatAIが話題ですが、AIの実態がこんな画像では、ChatAIも身体検査・適性検査・機能診断などの事前審査が必要な気がします。

特定の思想ばかりディープラーニングしたAIはとても恐ろしい。ディープラーニングのデータに偏りがないかを確認するベンチマークテストのようなものが必要かも知れません。どの組織でも職員を採用する際に思想信条に関するチェックを行っています。ChatAIにそれは不要なのでしょうか。

ディープラーニングに必要なデータを用意するのは人間です。もし、その人間が極度に偏った思想の持ち主だったとしたら、用意するデータ群は偏ったものになるでしょう。

テレビの番組を観ていると、お花畑の解説者ばかりで、ピント外れの解説をしているように感じます。問題視すべきは、ディープラーニングに使われたデータの内容と、その偏りをチェックするベンチマークなのではないでしょうか。

ネット上で話題になっているChatAIは、実は、「しりとり」さえ認識できないという代物です。指を三本指で表示する画像生成AIと何ら変わりません。その程度の実力と言うことです。その実態を隠し、一般社会で通用するかのようなことを言及している人は、ネタとして扱っているのでしょう。

最後に、巨大なにぎり寿司。サンプル画像を使ってもこの程度しか作れませんでした。残念です。

Google翻訳が使い物にならないことは、誰もが知っています。目先を変えてChatAIに投資する以前に、役に立たないGoogle翻訳の精度の向上を図って欲しい。